——机器道德:人工智能的伦理困境

目前,人工智能技术的迅猛发展已经在改变我们的日常生活,无论是在无人驾驶汽车、智能助手、智慧教育、智慧交通以及智能推荐系统中,人工智能系统正变得越来越智能化、个性化以及独立自主化,然而,随着这些人工智能产品的推出,这些产品的最终服务对象是人,所以这种智能、个性以及独立自主同时也会带来一个重要而且非常复杂问题——伦理道德。如比,一旦我们的工业智能设备嵌入了人工智能技术,那么引发的问题是这些机器设备是否具备符合论理的道德判断和行为准则,即是否具备机器道德。

那么究竟什么是机器道德呢?机器道德是指机器或计算机系统在执行任务或做出决策时所遵循的道德准则和价值观。随着人工智能系统变得越来越强大以及应用范围不断扩大,我们迫切需要思考机器道德的重要性,以确保这些智能机器或系统在我们的工业生产或社会活动中表现出良好的道德行为,机器道德不仅涉及到机器如何做出道德决策,更关乎我们作为人类如何去影响和引导机器的道德行为,它涉及到机器的价值取向、道德框架是否与人类价值观和道德准则保持一致,因些机器道德问题并不简单,不仅涉及到与人工智能机关的技术问题,更是一个涉及伦理、社会和文化层面的复杂问题。

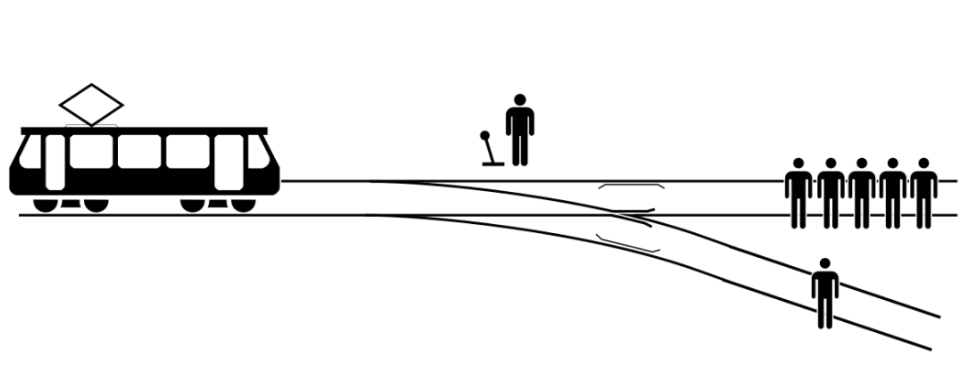

大家是否听说过历史上著名的“电车难题”?它最早是由哲学家菲利帕.福特(Philippa Foot)于1967年发表的一篇论文中被提出来的,用来批判伦理哲学中的主要理论,特别是功利主义。“电车难题”说的是一辆失控的列车在铁轨上行驶,在列车正行进的轨道上,有五个人被绑起来,无法动弹。列车将要碾压过他们。你能通过拉动拉杆来改变列车的走向,让其驶入另一条轨道上。但问题是另一条轨道上也绑着一个人。而你会怎么做?功利主义提出的观点是,大部分道德决策都是根据“为最多的人提供最大的利益”的原则做出的。严格意义上来说,这并不算一个真正的“问题”,而更倾向于一个“道德困境”,因为它没有一个真正正确的答案——没人能说出该怎样做才是真正正确的。也是因为如此,这个问题一直以来被广泛地讨论,而且永远是个能让人无数次争论的话题。

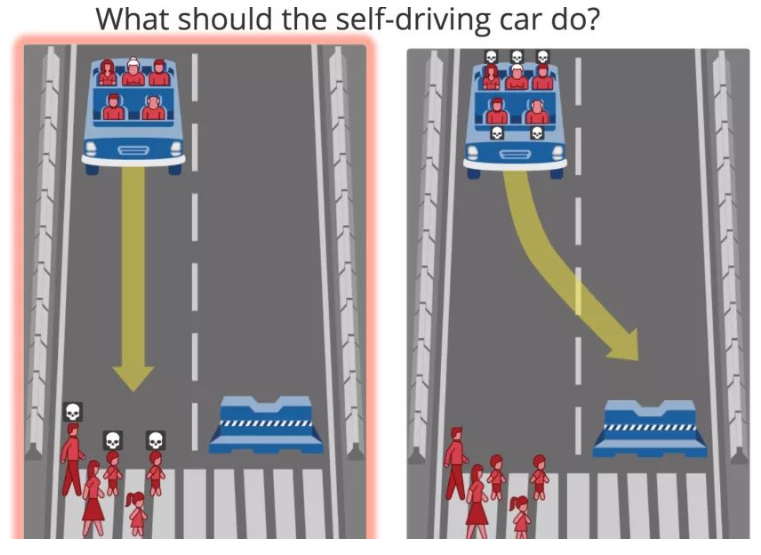

随着人工智能的发展,或许我们有一天也不得不去面对且正视“电车难题”,例如: 2016年,麻省理工学院上线了一个名为“道德机器”(Moral Machine)的在线实验平台,旨在探索自动驾驶汽车面临的道德困境。 在该平台上,人们需要决定自动驾驶下的汽车在危急关头更应该“牺牲”哪些人。

来自233个国家和地区的数百万用户参加了测验,共计制定了4000万个道德决策。根据这些数据,该研究的作者发现了一些较为一致的全球偏好(global preference):更倾向于拯救人类而不是动物、拯救多数人牺牲少数人、优先拯救儿童。

这些准则和价值观可以是由人类制定的,也可能是由机器自己学习和推导出来的。其根本目的是确保机器在执行任务时不会伤害人类或违反道德准则。如果要将道德决策编码到自动驾驶汽车里,就必须会形成一些偏好,例如,早在2014年,Google X的创始人Sebastian Thrun就表示,公司的原型自动驾驶汽车将在发生碰撞时选择撞击两个物体中的较小者。在2016耐能,谷歌的Chris Urmson表示,该公司的无人车将“尽量避免撞倒无保护的道路使用者:骑自行车的人和行人”。同年,据报道,梅赛德斯-奔驰的一名经理表示,该公司的自动驾驶汽车将优先考虑撞车事故中乘客的生命安全,但该公司后来否认了这一说法。

另外,由于人工智能系统的复杂性和不可预测性,很难确保机器不会出现意外的行为或错误决策。例如,如果一个自动驾驶汽车在遇到危险时必须做出决策,但是这个决策会导致车上的乘客受伤,应该怎么做?其次,由于机器学习算法的复杂性,很难理解机器如何做出决策或推理。这使得人们很难对机器的行为进行监督或纠正。例如,如果一个机器学习算法被训练成对某个群体进行歧视,但是这个歧视是由于数据偏差造成的,说得更直白一点,机器是不是“正直”是靠人类自已“喂”出来的,应该如何解决?这种情况下,我们需要对机器学习算法进行解释和解释能力的加强,以便人们能够理解机器是如何做出决策的,并且能够对机器的行为进行监督和纠正。

最后,由于人工智能系统的普及和广泛应用,机器道德问题已经成为一个全球性的问题。不同国家和文化对机器道德的理解和要求可能存在差异,这可能导致机器在执行任务时出现冲突或矛盾。例如,一个在美国开发的人工智能系统可能会在中国遇到不同的道德准则和文化背景。因此,我们需要加强跨文化交流和协调,以确保未来的智能机器在不同的文化背景下能够遵循适当的道德准则。