讲解视频:

建图、定位与导航(实验3、实验4)

实验目的:

在SLAM的基础上,对机器人在现有地图上进行定位,设定目标点后进行导航。

步骤1:开启机器人并进行连接

(0)如果机器人电量不足,请充电(用输出电压为19V充电器)

(1)开启机器人,记录其热点名称(spark-xxx)及IP地址(一般为10.42.0.1)

(2)启动笔记本或台式电脑,通过无线网卡连接机器人热点(spark-xxx)

(3)在笔记本或台式电脑上启动VNCViewer,通过机器人IP连接到机器人。

步骤2:根据实验3的步骤,建立机器人所在环境的地图,设地图文件保存在spark用户的home目录下,文件名为mymap01 (注:将保存两个文件:mympa01.yaml,mymap01.pgm)

(注:请尽可能让机器人在墙壁边上行走一段距离,便于后面的定位)

步骤3:

启动自主导航的launch文件:

roslaunch spark_navigation amcl_demo_lidar_rviz.launch camera_type_tel:=astrapro map_file:=/home/spark/mymap01.yaml

(注:其中,参数map_file的内容根据你所保存的地图文件修改)

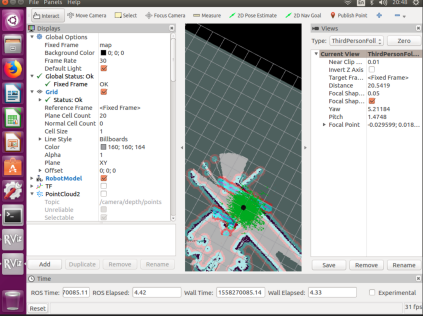

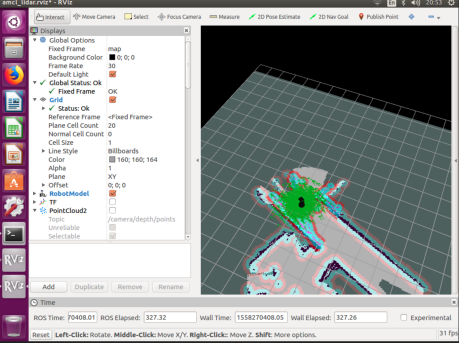

正常启动后,将出现类似如下的界面:

步骤4:机器人初始位姿估计

根据机器人实际位置,设置其在地图上的初始位置及方向

点击2D Pose Estimate键,然后按住不松手,设置方向,如图我们已经更改了机器人到正确的初始位置。

(评判标准是:激光雷达扫描的点与地图边界重合的比较好,其中红色点为激光雷达扫描的点。

以上是手工进行的操作,如果用程序实现了,那么就实现的自主导航中我在哪里的问题!)

步骤5:选择导航目的地

设置目的地及方向,使用2D Nav Goal按钮进行设置,等待机器人进行路径规划

当出现Goal reached时,说明已经达到目的地;已完成本次自主导航任务。