-

1.1第1章 信息检索基础知识

-

1.1.11.1 信息、知识、文献

-

1.1.1.11.1.1 信息

-

1.1.1.21.1.2 知识

-

1.1.1.31.1.3 文献

-

1.1.1.41.1.4 信息、知识和文献的相互关系

-

1.1.21.2 信息资源类型

-

1.1.2.11.2.1 按信息加工层次划分

-

1.1.2.21.2.2 按表述方式划分

-

1.1.2.31.2.3 按载体类型划分

-

1.1.2.41.2.4 按出版类型划分

-

1.1.31.3 信息检索工具

-

1.1.3.11.3.1 信息检索工具概念

-

1.1.3.21.3.2 检索工具的类型

-

1.1.41.4 信息检索语言

-

1.1.4.11.4.1 信息检索语言的概念及作用

-

1.1.4.21.4.2 检索语言的类型

-

1.1.51.5 信息检索途径、方法与技术

-

1.1.5.11.5.1 文献信息检索的途径

-

1.1.5.21.5.2 信息检索方法

-

1.1.5.31.5.3 计算机检索的基本技术

-

1.1.61.6 信息检索的流程与评价

-

1.1.6.11.6.1 信息检索的基本流程

-

1.1.6.21.6.2 文献检索效果评价

-

1.1.7思考题

-

1.2第2章 参考工具书简介

-

1.2.12.1 参考工具书概述

-

1.2.1.12.1.1 参考工具书概念与特点

-

1.2.1.22.1.2 参考工具书结构与排检方法

-

1.2.22.2 参考工具书类型与应用

-

1.2.2.12.2.1 参考工具书类型

-

1.2.2.22.2.2 参考工具书应用

-

1.2.32.3 中国大百科全书数据库及其利用

-

1.2.3.12.3.1 中国大百科全书浏览功能和检索功能

-

1.2.3.22.3.2 中国大百科全书丰富的附加资源

-

1.2.3.32.3.3 中国大百科全书辅助的查阅功能

-

1.2.4思考题

-

1.3第3章 网络搜索引擎及其应用

-

1.3.13.1 搜索引擎概述

-

1.3.1.13.1.1 搜索引擎的概念

-

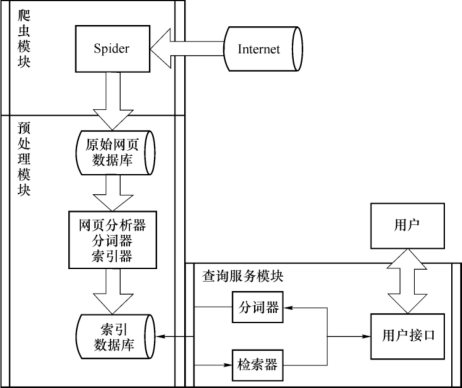

1.3.1.23.1.2 搜索引擎的原理

-

1.3.1.33.1.3 搜索引擎的类型

-

1.3.1.43.1.4 搜索引擎的基本检索技术

-

1.3.1.53.1.5 搜索引擎的发展历程

-

1.3.23.2 常用搜索引擎

-

1.3.2.13.2.1 百度

-

1.3.2.23.2.2 必应

-

1.3.2.33.2.3 搜狗搜索

-

1.3.2.43.2.4 360搜索

-

1.3.2.53.2.5 中国搜索

-

1.3.33.3 外文搜索引擎的使用

-

1.3.3.13.3.1 Google

-

1.3.3.23.3.2 Yahoo!

-

1.3.3.33.3.3 Excite

-

1.3.3.43.3.4 Lycos

-

1.3.3.53.3.5 Ask

-

1.3.3.63.3.6 Dogpile

-

1.3.43.4 搜索引擎的未来趋势

-

1.3.4.13.4.1 搜索引擎需求市场分析

-

1.3.4.23.4.2 用户对搜索引擎发展的要求

-

1.3.4.33.4.3 搜索引擎发展特点和趋势

-

1.3.5思考题

-

1.4第4章 国内主要文献资源检索系统及其利用

-

1.4.14.1 学术搜索与全文递送系统

-

1.4.1.14.1.1 学术搜索与全文递送系统简介

-

1.4.1.24.1.2 学术搜索与全文递送系统检索方法

-

1.4.24.2 中国知网

-

1.4.2.14.2.1 中国知网资源简介

-

1.4.2.24.2.2 中国知网检索方法

-

1.4.2.34.2.3 中国知网检索结果处理

-

1.4.34.3 超星数字资源

-

1.4.3.14.3.1 超星电子图书及其检索

-

1.4.3.24.3.2 超星名师讲坛及其检索

-

1.4.44.4 多媒体学习资源

-

1.4.4.14.4.1 新东方多媒体学习库

-

1.4.4.24.4.2 名人名家网上报告厅

-

1.4.4.34.4.3 就业数字图书馆

-

1.4.5思考题

-

1.5第5章 国外主要文献资源检索系统及其利用

-

1.5.15.1 WOS数据库

-

1.5.1.15.1.1 WOS概述

-

1.5.1.25.1.2 WOS检索方法、技术与结果处理

-

1.5.1.35.1.3 WOS检索实例

-

1.5.25.2 EI数据库

-

1.5.2.15.2.1 EI概述

-

1.5.2.25.2.2 EI检索方法、技术与结果处理

-

1.5.2.35.2.3 EI检索实例

-

1.5.35.3 SciFinder数据库

-

1.5.3.15.3.1 SciFinder概述

-

1.5.3.25.3.2 SciFinder检索方法、技术与结果处理

-

1.5.3.35.3.3 SciFinder检索实例

-

1.5.45.4 Elsevier SDOL数据库

-

1.5.4.15.4.1 Elsevier SDOL概述

-

1.5.4.25.4.2 Elsevier SDOL检索方法、技术与结果处理

-

1.5.4.35.4.3 Elsevier SDOL检索实例

-

1.5.5思考题

-

1.6第6章 特种文献及其检索

-

1.6.16.1 科技报告

-

1.6.1.16.1.1 科技报告概述

-

1.6.1.26.1.2 科技报告的特点及类型

-

1.6.1.36.1.3 国外科技报告检索

-

1.6.1.46.1.4 国内科技报告检索

-

1.6.26.2 专利文献

-

1.6.2.16.2.1 专利概述

-

1.6.2.26.2.2 专利文献概述

-

1.6.2.36.2.3 国外专利文献检索

-

1.6.2.46.2.4 国内专利文献检索

-

1.6.36.3 标准文献

-

1.6.3.16.3.1 标准文献概述

-

1.6.3.26.3.2 国内标准文献检索

-

1.6.3.36.3.3 国际标准文献检索

-

1.6.46.4 会议文献

-

1.6.4.16.4.1 会议文献概述

-

1.6.4.26.4.2 国内会议文献检索

-

1.6.4.36.4.3 国外会议文献检索

-

1.6.56.5 学位论文

-

1.6.5.16.5.1 学位论文概述

-

1.6.5.26.5.2 国内学位论文检索

-

1.6.5.36.5.3 国外学位论文检索

-

1.6.6思考题

-

1.7第7章 信息检索综合利用

-

1.7.17.1 科技查新

-

1.7.1.17.1.1 科技查新的概述

-

1.7.1.27.1.2 查新工作程序

-

1.7.1.37.1.3 科技查新案例

-

1.7.27.2 文献信息管理工具应用

-

1.7.2.17.2.1 NoteExpress

-

1.7.2.27.2.2 EndNote

-

1.7.37.3 科技论文撰写与投稿

-

1.7.3.17.3.1 科技论文的基础知识

-

1.7.3.27.3.2 科技论文的撰写

-

1.7.3.37.3.3 科技论文投稿指南

-

1.7.47.4 学位论文的写作与规范

-

1.7.4.17.4.1 概述

-

1.7.4.27.4.2 学位论文的选题

-

1.7.4.37.4.3 学位论文的撰写

-

1.7.4.47.4.4 学位论文的答辩

-

1.7.5思考题

-

1.8第8章 网络免费信息资源导航

-

1.8.18.1 工学网络资源

-

1.8.1.18.1.1 机械类资源

-

1.8.1.28.1.2 电气信息类资源

-

1.8.1.38.1.3 能源动力类资源

-

1.8.1.48.1.4 仪器仪表类资源

-

1.8.1.58.1.5 生物工程类资源

-

1.8.1.68.1.6 化学工程类资源

-

1.8.1.78.1.7 材料工程类资源

-

1.8.1.88.1.8 食品工程类资源

-

1.8.1.98.1.9 环境工程类资源

-

1.8.28.2 理学网络资源

-

1.8.2.18.2.1 化学类资源

-

1.8.2.28.2.2 材料物理类资源

-

1.8.2.38.2.3 数学类资源

-

1.8.38.3 社会学网络资源

-

1.8.3.18.3.1 经济学类资源

-

1.8.3.28.3.2 法学类资源

-

1.8.3.38.3.3 社会学类资源

-

1.8.3.48.3.4 体育类资源

-

1.8.48.4 管理学网络资源

-

1.8.4.18.4.1 管理科学与工程类资源

-

1.8.4.28.4.2 工商管理类资源

-

1.8.4.38.4.3 公共管理类资源

-

1.8.58.5 人文科学网络资源

-

1.8.5.18.5.1 中国语言学类资源

-

1.8.5.28.5.2 外国语言学网络资源

-

1.8.5.38.5.3 艺术类网络资源

-

1.8.68.6 考研、就业网络资源

-

1.8.6.18.6.1 研究生考试网络资源

-

1.8.6.28.6.2 就业信息网络资源

-

1.8.7思考题

-

1.9第9章 信息法规与学术规范

-

1.9.19.1 信息法规

-

1.9.1.19.1.1 信息法规概述

-

1.9.1.29.1.2 信息法规的发展

-

1.9.1.39.1.3 信息利用相关法规

-

1.9.29.2 信息道德

-

1.9.2.19.2.1 信息道德概述

-

1.9.2.29.2.2 信息道德建设

-

1.9.2.39.2.3 学术道德危机与学术道德建设

-

1.9.2.49.2.4 网络道德危机与网络道德建设

-

1.9.39.3 信息利用规范

-

1.9.3.19.3.1 论文写作信息利用规范

-

1.9.3.29.3.2 数据库信息利用规范

-

1.9.3.39.3.3 网络信息利用规范

-

1.9.3.49.3.4 共建信息利用规范

-

1.9.4思考题

-

1.10参考文献

1

文献信息 检索教程 第2版