-

1.1编委会

-

1.2再版前言

-

1.3再版说明

-

1.4第一章 计算机基础知识

-

1.4.1第一节 计算机的基本概念

-

1.4.1.1一、计算机的发展

-

1.4.1.2二、超级计算机

-

1.4.1.3三、微型计算机的发展

-

1.4.1.4四、计算机的分类

-

1.4.1.5五、计算机的主要特点

-

1.4.1.6六、计算机的主要用途

-

1.4.1.7七、信息的基本概念

-

1.4.2第二节 计算机系统的组成

-

1.4.2.1一、硬件系统

-

1.4.2.2二、软件系统

-

1.4.2.3三、计算机中数据存储概念

-

1.4.3第三节 信息编码

-

1.4.3.1一、数值在计算机中的表示形式

-

1.4.3.2二、宇符编码

-

1.4.4第四节 微型计算机的硬件组成

-

1.4.4.1一、CPU、内存、接口、总线的概念

-

1.4.4.2二、微处理器、微型计算机和微型计算机系统的概念

-

1.4.4.3三、常用外部设备

-

1.4.4.4四、微型计算机的主要性能指标及配置

-

1.4.5小结

-

1.4.6实践与解析

-

1.5第二章 Windows操作系统

-

1.5.1第一节 操作系统基本知识

-

1.5.1.1一、操作系统概述

-

1.5.1.2二、个八计算机操作系统和网络操作系统

-

1.5.1.3三、微机操作系统操作环境的演变与发展

-

1.5.1.4四、Windows操作系统

-

1.5.2第二节 Windows的基本操作

-

1.5.2.1一、Windows运行环境简介

-

1.5.2.2二、Windows的启动和退出

-

1.5.2.3三、Windows桌面及桌面操作

-

1.5.2.4四、窗口和对话框及其操作

-

1.5.2.5五、Windows中文输入法及其操作

-

1.5.3第三节 Windows资源管理器

-

1.5.3.1一、Windows的文件系统

-

1.5.3.2二、资源管理器及其操作

-

1.5.3.3三、文件夹和文件的浏览与查看

-

1.5.3.4四、文件夹和文件的基本操作

-

1.5.3.5五、磁盘操作

-

1.5.4第四节 Windows系 统环境设置

-

1.5.4.1一、控制面板的启动

-

1.5.4.2二、Windows显示属性的设置

-

1.5.4.3三、时钟、语言和区域设置

-

1.5.4.4四、程序的更新和删除

-

1.5.5第五节 附件及应用程序

-

1.5.5.1一、画图

-

1.5.5.2二、记事本

-

1.5.5.3三、便签

-

1.5.5.4四、Tablet PC

-

1.5.5.5五、写宇板

-

1.5.5.6六、计算器

-

1.5.5.7七、Windows的系统工具

-

1.5.5.8八、Windows中的命令行方式

-

1.5.6小结

-

1.5.7实践与解析

-

1.6第三章 Word 2010文字处理

-

1.6.1第一节 Word 2010文档基本知识

-

1.6.1.1一、Word 2010的主要功能

-

1.6.1.2二、Word 2010的启动和退出

-

1.6.1.3三、Word 2010操作界面

-

1.6.1.4四、Word 2010帮助命令的使用

-

1.6.2第二节 Word 2010文件操作

-

1.6.2.1一、新建文档

-

1.6.2.2二、打开已有文档

-

1.6.2.3三、保存文档

-

1.6.2.4四、关闭文档

-

1.6.3第三节 文本的输入与编辑

-

1.6.3.1一、文本的输入

-

1.6.3.2二、文本的编辑

-

1.6.4第四节 Word 2010文档的排版操作

-

1.6.4.1一、宇符格式的设置

-

1.6.4.2二、段落格式的设置

-

1.6.4.3三、首宇下沉设置

-

1.6.4.4四、分栏排版

-

1.6.4.5五、项目符号和自动编号的设置

-

1.6.4.6六、边框和底纹的设置

-

1.6.4.7七、页眉和页脚的设置

-

1.6.4.8八、插入页码

-

1.6.5第五节 表格制作

-

1.6.5.1一、表格的建立

-

1.6.5.2二、表格格式和内容的编辑

-

1.6.5.3三、表格的设置

-

1.6.6第六节 图文混排

-

1.6.6.1一、插入图片

-

1.6.6.2二、艺术宇

-

1.6.6.3三、插入自选图形

-

1.6.6.4四、文本框

-

1.6.6.5五、SmartArt图形

-

1.6.6.6六、屏幕截图

-

1.6.6.7七、水印

-

1.6.7第七节 文档模板与样式

-

1.6.7.1一、模板

-

1.6.7.2二、样式

-

1.6.8第八节 文档页面设置和打印输出

-

1.6.8.1一、页面的设置

-

1.6.8.2二、打印预览

-

1.6.8.3三、打印

-

1.6.9小结

-

1.6.10实践与解析

-

1.7第四章 Excel电子表格

-

1.7.1第一节 Excel基础知识

-

1.7.1.1一、Excel的基本操作

-

1.7.1.2二、Excel工作簿的基本操作

-

1.7.1.3三、Excel中的数据类型

-

1.7.2第二节 Excel工作表的操作

-

1.7.2.1一、Excel工作表的编辑

-

1.7.2.2二、Excel工作表的整体操作

-

1.7.2.3三、Excel工作表的打印输出

-

1.7.3第三节 Excel公式与函数

-

1.7.3.1一、Excel单元格引用

-

1.7.3.2二、Excel公式的使用

-

1.7.3.3三、Excel函数的使用

-

1.7.4第四节 Excel数据处理

-

1.7.4.1一、数据排序

-

1.7.4.2二、数据筛选

-

1.7.4.3三、分类汇总

-

1.7.5第五节 Excel图表

-

1.7.5.1一、图表的建立

-

1.7.5.2二、图表的编辑

-

1.7.5.3三、迷你图的创建

-

1.7.6小结

-

1.7.7实践与解析

-

1.8第五章 PowerPoint电子演示文稿

-

1.8.1第一节 PowerPoint的基本操作

-

1.8.1.1一、启动PowerPoint及其窗口的组成

-

1.8.1.2二、演示文稿的基本操作

-

1.8.2第二节 PowerPoint的外观设计

-

1.8.2.1一、幻灯片的主题设计

-

1.8.2.2二、幻灯片的背景设计

-

1.8.2.3三、幻灯片的母版视图

-

1.8.3第三节 PowerPoint的动画设计

-

1.8.3.1一、动画设置

-

1.8.3.2二、动作设置

-

1.8.3.3三、超链接设置

-

1.8.3.4四、幻灯片切换设置

-

1.8.4第四节 PowerPoint的放映

-

1.8.4.1一、幻灯片的放映

-

1.8.4.2二、幻灯片放映方式的设置

-

1.8.5小结

-

1.8.6实践与解析

-

1.9第六章 计算机网络基础

-

1.9.1第一节 网络基本概念

-

1.9.1.1一、什么是计算机网络

-

1.9.1.2二、网络的组成与结构

-

1.9.1.3三、局域网

-

1.9.1.4四、网络安全

-

1.9.2第二节 Internet概述

-

1.9.2.1一、Internet起源与发展

-

1.9.2.2二、Internet基础知识

-

1.9.2.3三、Internet提供的服务

-

1.9.3第三节 Internet接入方式

-

1.9.3.1一、电话宽带接入

-

1.9.3.2二、有线电视接入

-

1.9.3.3三、局域网接入

-

1.9.3.4四、无线接入

-

1.9.3.5五、代理服务器接入

-

1.9.3.6六、网络故障的简单诊断命令

-

1.9.4第四节 网络常用工具软件

-

1.9.4.1一、即时通信工具QQ

-

1.9.4.2二、网络博客

-

1.9.4.3三、网络多媒体播放工具PPLive

-

1.9.4.4四、网络高速下载工具迅雷

-

1.9.5第五节 网络医药信息资源

-

1.9.5.1一、医药数据库资源

-

1.9.5.2二、电子出版物资源

-

1.9.5.3三、医学新闻资源

-

1.9.5.4四、医学教育资源

-

1.9.5.5五、生物医学软件资源

-

1.9.5.6六、循证医学资源

-

1.9.5.7七、其他医药信息资源

-

1.9.6小结

-

1.9.7实践与解析

-

1.10第七章 Internet应用

-

1.10.1第一节 IE浏览器的使用

-

1.10.1.1一、Internet网页的几个基本术语

-

1.10.1.2二、IE浏览器的启动与退出

-

1.10.1.3三、IE浏览器界面

-

1.10.1.4四、IE浏览器的基本操作

-

1.10.1.5五、IE浏览器的基本设置

-

1.10.1.6六、IE浏览器收藏夹的基本使用

-

1.10.1.7七、搜索引擎的使用

-

1.10.1.8八、访问FTP站点的操作

-

1.10.1.9九、博客

-

1.10.1.10十、社交网络服务

-

1.10.1.11十一、Web格式的邮件使用

-

1.10.2第二节 电子邮件的使用

-

1.10.2.1一、电子邮件的基本工作原理

-

1.10.2.2二、电子邮件的基本知识

-

1.10.2.3三、添加邮件账户

-

1.10.2.4四、Outlook邮件的基本操作

-

1.10.2.5五、Outlook邮件的管理

-

1.10.2.6六、联系八的使用

-

1.10.3小结

-

1.10.4实践与解析

-

1.11第八章 计算机安全技术

-

1.11.1第一节 计算机安全的基本知识和概念

-

1.11.1.1一、计算机安全的概念和属性

-

1.11.1.2二、影响计算机安全的主要因素和安全标准

-

1.11.2第二节 计算机安全服务的主要技术

-

1.11.2.1一、网络攻击

-

1.11.2.2二、安全服务

-

1.11.3第三节 防火墙、系统更新与系统还原

-

1.11.3.1一、防火墙

-

1.11.3.2二、系统更新

-

1.11.3.3三、系统还原

-

1.11.4第四节 计算机病毒和木马的基本知识和预防

-

1.11.4.1一、计算机病毒的概念

-

1.11.4.2二、计算机病毒的特性

-

1.11.4.3三、计算机病毒的分类

-

1.11.4.4四、计算机病毒的表现形式

-

1.11.4.5五、木马

-

1.11.4.6六、计算机病毒和木马的预防

-

1.11.4.7七、计算机病毒的清除

-

1.11.4.8八、360安全卫士介绍

-

1.11.5第五节 网络道德

-

1.11.6小结

-

1.11.7实践与解析

-

1.12第九章 计算机多媒体技术

-

1.12.1第一节 多媒体技术基本知识

-

1.12.1.1一、媒体

-

1.12.1.2二、多媒体与多媒体技术

-

1.12.1.3三、多媒体计算机与多媒体设备

-

1.12.1.4四、多媒体技术在网络教育中的作用

-

1.12.2第二节 多媒体信息处理

-

1.12.2.1一、声音信息处理

-

1.12.2.2二、图形图像信息处理

-

1.12.2.3三、视频信息处理

-

1.12.3第三节 数据压缩技术

-

1.12.3.1一、数据冗余与压缩

-

1.12.3.2二、文件压缩解压缩工具WinRAR基本操作

-

1.12.4第四节 实用多媒体技术

-

1.12.4.1一、网络多媒体素材搜集

-

1.12.4.2二、多媒体素材整理与加工

-

1.12.4.3三、常见的多媒体开发工具

-

1.12.5小结

-

1.12.6实践与解析

-

1.13第十章 大数据概论

-

1.13.1第一节 大数据技术概述

-

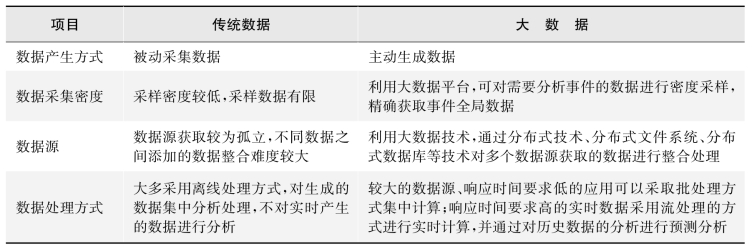

1.13.1.1一、大数据的基本概念

-

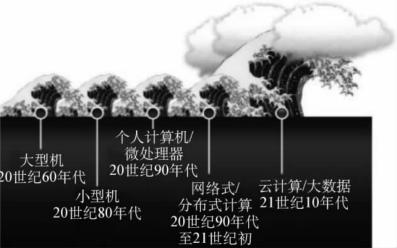

1.13.1.2二、IT产业的发展简史

-

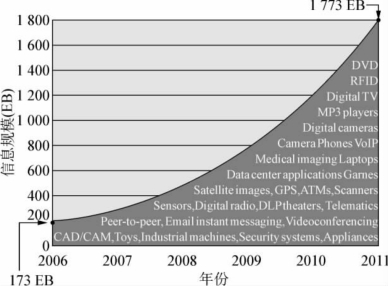

1.13.1.3三、大数据的来源

-

1.13.1.4四、大数据产生的三个阶段

-

1.13.1.5五、大数据的特点

-

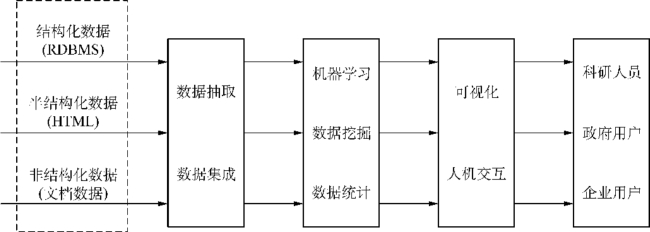

1.13.1.6六、大数据处理的基本流程

-

1.13.1.7七、大数据的数据格式特性

-

1.13.1.8八、大数据的特征

-

1.13.1.9九、大数据的应用领域

-

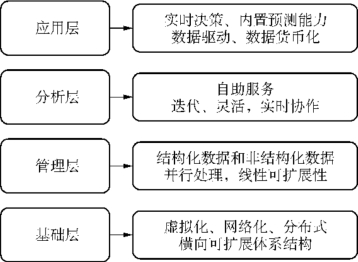

1.13.2第二节 大数据技术架构

-

1.13.3第三节 大数据的整体技术和关键技术

-

1.13.3.1一、整体技术

-

1.13.3.2二、关键技术

-

1.13.4第四节 大数据分析的五种典型工具简介

-

1.13.4.1一、Hadoop

-

1.13.4.2二、HPCC

-

1.13.4.3三、Storm

-

1.13.4.4四、Apache Drill

-

1.13.4.5五、Rapid Miner

-

1.13.5第五节 大数据未来发展趋势

-

1.13.5.1一、数据资源化

-

1.13.5.2二、数据科学和数据联盟的成立

-

1.13.5.3三、大数据隐私和安全问题

-

1.13.5.4四、开源软件成为推动大数据发展的动力

-

1.13.5.5五、大数据在多方位改善八们的生活

-

1.13.6小结

-

1.13.7实践与解析

1

计算机应用基础

1.13.7

实践与解析