-

1 教学视频

-

2 课程思政

-

3 章节测试

-

4 拓展学习

一、知识点学习

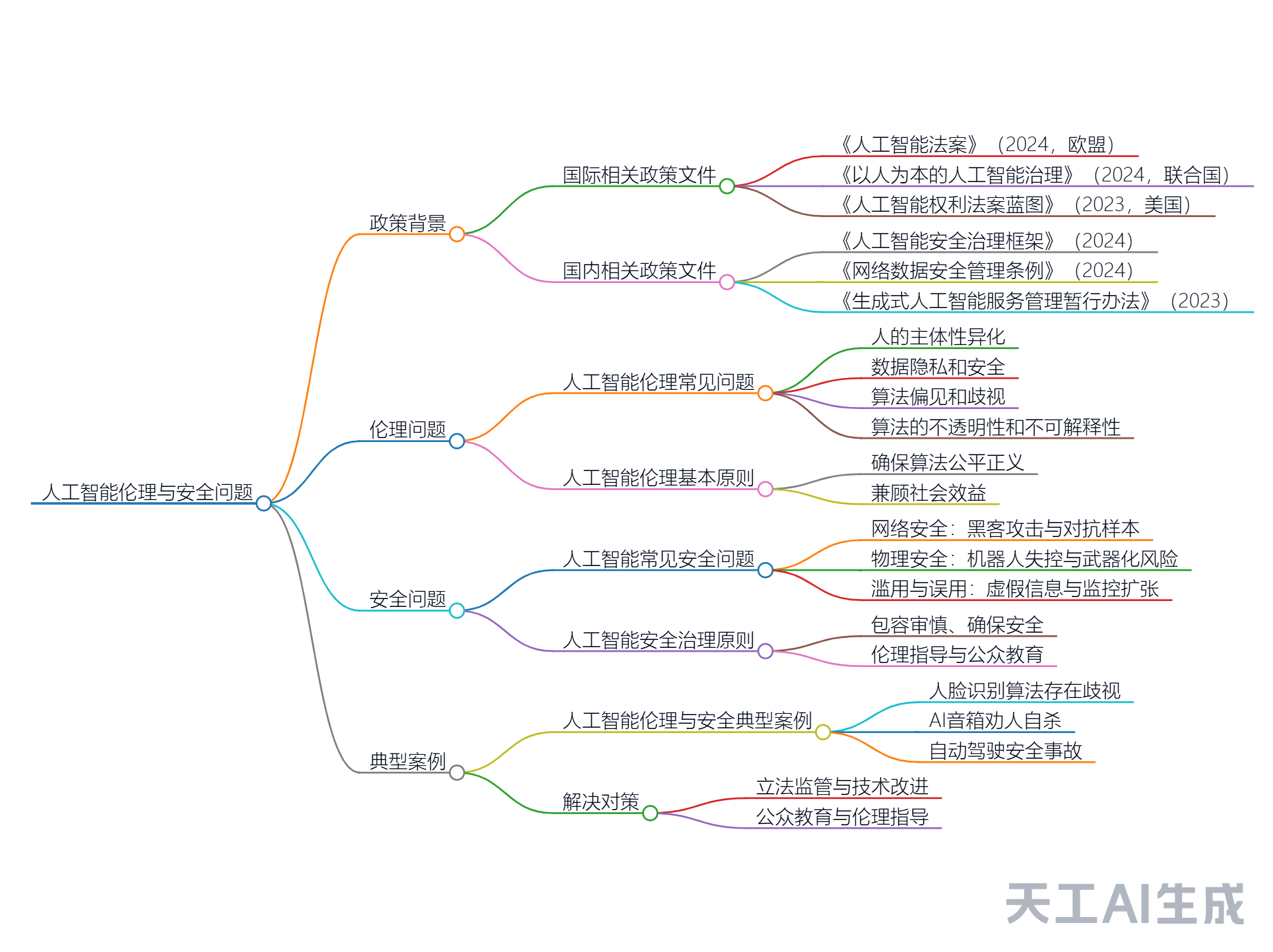

二、思维导图(知识点总结)

三、学习笔记

总体概要

本文深入探讨了机器学习与深度学习在人工智能领域的关键作用,介绍了监督学习与无监督学习两种主要学习方式,以及神经网络与深度学习如何模拟人脑工作机制,构建智能模型。文章还阐述了强化学习通过试错机制使AI自我进化的方法,并展望了机器学习在医疗、自动驾驶、个性化购物、金融安全、智能家居、能源管理等领域的广泛应用前景。核心思想是机器学习是推动AI技术进步的重要力量,它通过模仿人类学习方式和大脑结构,使机器能够自主学习、进化,并在多个领域实现智能化,从而深刻改变我们的生活和工作方式。

核心要点

监督学习与无监督学习:

监督学习需要带有标签的数据来训练模型,适用于有明确答案的问题;无监督学习则不需要标签,适用于探索数据内在结构和模式。

神经网络与深度学习:

神经网络模仿人脑的工作方式,由多个节点(神经元)及其连接构成;深度学习利用多层神经网络自动从数据中学习复杂特征,推动了图像识别、语音识别等领域的进步。

强化学习:

强化学习通过试错和结果反馈来指导机器学习,适用于复杂任务如机器人行走和AlphaGo等高级AI应用。

机器学习的应用领域:

机器学习在医疗诊断、自动驾驶、个性化购物、金融安全、智能家居等领域有广泛应用,并有望进一步发展。

机器学习的未来前景:

预计机器学习将在工作自动化、AR/VR体验、精准农业、环境保护等方面发挥更大作用,并与量子计算结合可能带来重大突破。

段落概要

1. 政策背景

1.1 国际相关政策文件

《人工智能法案》(2024,欧盟):旨在为人工智能的开发和应用提供法律框架。

《以人为本的人工智能治理》(2024,联合国):强调人工智能应以人类福祉为中心。

《人工智能权利法案蓝图》(2023,美国):提出保护个人在人工智能应用中的权利。

《关于安全、可靠、可信地开发和使用人工智能的行政命令》(2023,美国):要求确保人工智能的安全性和可靠性。

《2022 年算法问责法案》(2022,美国):关注算法的透明度和问责制。

1.2 国内相关政策文件

《人工智能安全治理框架》(2024):为国内人工智能的安全治理提供指导。

《网络数据安全管理条例》(2024):规范网络数据的安全管理。

《人工智能生成合成内容标识办法》(2024):要求对生成内容进行标识,以确保透明性。

《新一代人工智能伦理规范》(2021):提出人工智能发展的伦理要求。

2. 伦理问题

2.1 人工智能伦理常见问题

人的主体性异化:随着人工智能的发展,人类在智能机器面前的主体性逐渐被削弱,可能导致人类被视为机器的“零部件”。

数据隐私和安全:人工智能应用中涉及大量个人数据的收集和存储,若数据泄露,可能严重侵犯个人隐私。

算法偏见和歧视:算法的决策可能存在偏见,导致某些群体受到不公平对待。

算法的不透明性和不可解释性:许多算法的决策过程复杂且难以理解,影响其在关键领域的应用信任度。

AI系统的不稳定性和风险性:AI系统的性能可能因数据波动、算法更新和硬件故障而不稳定。

责任归属:在人工智能应用中,涉及数据隐私、算法决策等多个方面的责任归属问题。

公平正义和社会效益:人工智能应用需兼顾经济效益与社会效益,确保公平性。

人工智能在教育领域引发的伦理问题:AI在教育中的应用可能导致数据隐私问题和教育不公平现象。

2.2 人工智能伦理基本原则

确保人工智能技术的发展和应用符合人类的价值观和道德标准。

3. 安全问题

3.1 人工智能常见安全问题

网络安全:AI系统易成为黑客攻击的目标,可能导致数据泄露。

物理安全:如工业机器人和自动驾驶汽车失控,可能危及人身安全。

滥用与误用:AI技术可能被用于制造虚假信息和进行过度监控。

长期风险:超级智能的出现可能带来无法预测的后果。

3.2 人工智能安全治理原则

包容审慎、确保安全:在发展创新的同时,确保安全底线。

伦理指导:建立行业自律组织,制定伦理准则。

技术改进:开发更安全可靠的AI算法,提高透明度和可解释性。

公众教育:提升民众对新技术的理解和支持度。