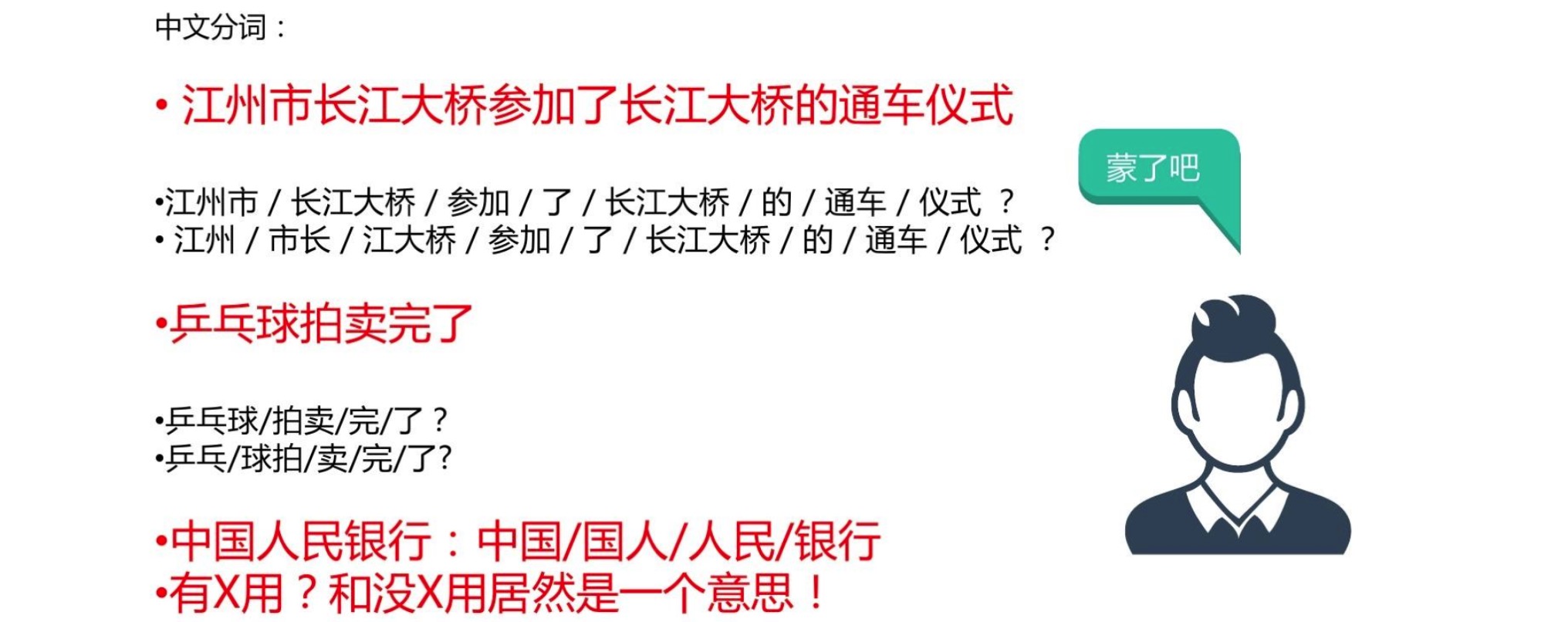

对于中文和日文这样的特殊亚洲语系文本而言,字和字之间是紧密相连的,单纯从文本形态上无法区分具备独立含义的词(拉丁语系纯天然由空格分隔不同的word),而不同的词以不同的方式排布,可以表达不同的内容和情感,因此在很多中文任务中,我们需要做的第一个处理叫做分词。

这是一个非常基础的功能,但是会较大程度影响下游任务(机器翻译、情感分析、文本理解)的效果。

目前主流的分词方法主要是基于词典匹配的分词方法(正向最大匹配法、逆向最大匹配法和双向匹配分词法等)和基于统计的分词方法(HMM、CRF、和深度学习);主流的分词工具库包括 中科院计算所NLPIR、哈工大LTP、清华大学THULAC、Hanlp分词器、Python jieba工具库等。

关于分词方法和工具库更多内容可以参考知乎讨论有哪些比较好的中文分词方案

2.停用词与N-gram

在自然语言处理的很多任务中,我们处理的主体“文本”中有一些功能词经常出现,然而对于最后的任务目标并没有帮助,甚至会对统计方法带来一些干扰,我们把这类词叫做**停用词**,通常我们会用一个停用词表把它们过滤出来。比如英语当中的**定冠词/不定冠词**(a,an,the等)。

中文当中常用到的停用词词表可以参见[中文常用停用词表](https://github.com/goto456/stopwords)

关于机器学习中停用词的产出与收集方法,大家可以参见知乎讨论[机器学习中如何收集停用词](https://www.zhihu.com/question/34939177)

N-gram

N-gram在中文中叫做n元语法,指文本中连续出现的n个语词。n元语法模型是基于(n-1)阶马尔可夫链的一种概率语言模型,通过n个语词出现的概率来推断语句的结构。关于语言模型的更多内容,我们在后续的课程会详细提到。

大家可以简单理解成N-gram是N个词条组成的n元组,也可以阅读[自然语言处理中N-Gram模型介绍](https://zhuanlan.zhihu.com/p/32829048)了解更多内容。

3.更多任务(词性标注、依赖分析、NER、关键词抽取)

词性标注

词性(part-of-speech)是词汇基本的语法属性,通常也称为词性。

词性标注(part-of-speech tagging),又称为词类标注或者简称标注,是指为分词结果中的每个单词标注一个正确的词性的程序,也即确定每个词是名词、动词、形容词或者其他词性的过程。

词性标注是很多NLP任务的预处理步骤,如句法分析,经过词性标注后的文本会带来很大的便利性,但也不是不可或缺的步骤。

句法依存分析

在很多复杂的NLP问题中,我们还需要完成句法分析的任务,更具体一点说,需要确定句子的句法结构,确定句子中各词之间的依存关系。下图为Stanford nlp parser解析得到的结果(对分完词后的句子)

命名实体识别

命名实体识别(Named Entity Recognition, NER)是从一段非结构化文本中找出相关实体(triplet中的主词和宾词),并标注出其位置以及类型,它是NLP领域中一些复杂任务(如关系抽取、信息检索、知识问答、知识图谱等)的基础。

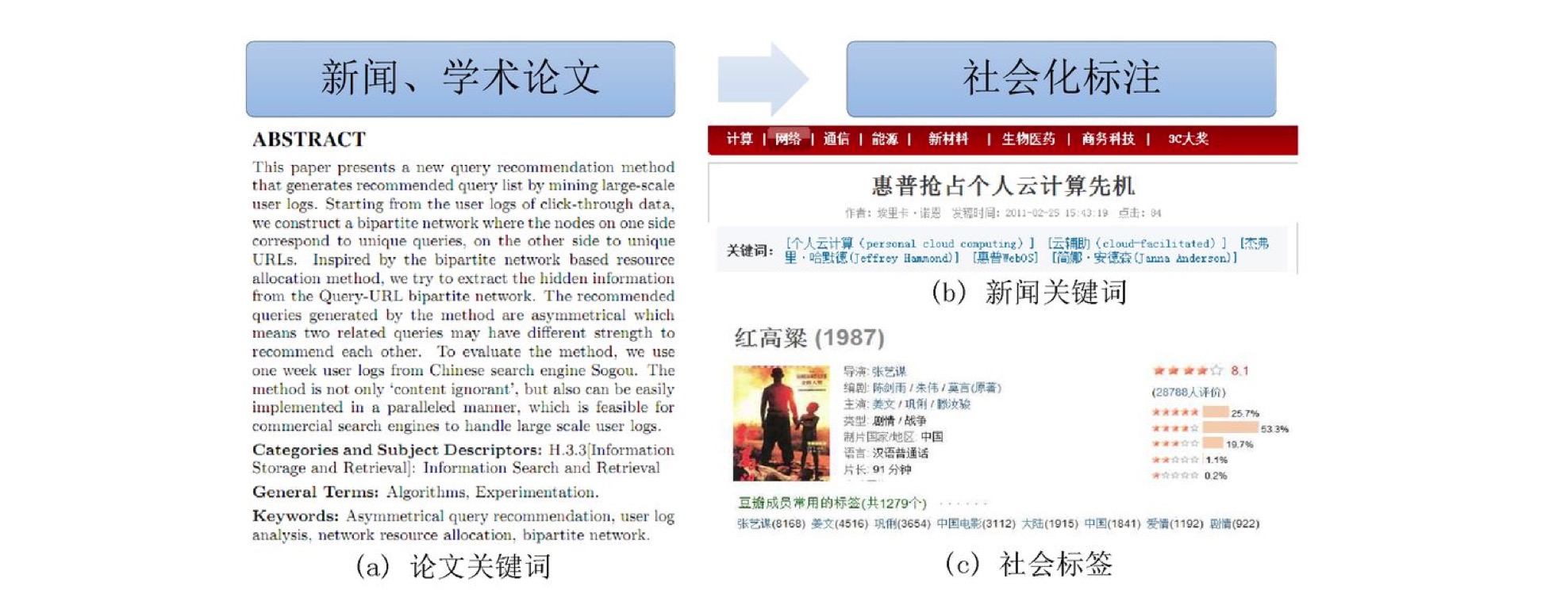

关键词抽取

文本关键词抽取,是对文本信息进行高度凝练的一种有效手段,通过3-5个词语准确概括文本的主题,帮助读者快速理解文本信息。是文本检索、文本摘要等许多下游文本挖掘任务的基础性和必要性的工作。

4.jieba工具库使用

a.基本分词函数与用法

jieba.cut 以及 jieba.cut_for_search 返回的结构都是一个可迭代的 generator,可以使用 for 循环来获得分词后得到的每一个词语(unicode)

jieba.cut 方法接受三个输入参数:

* 需要分词的字符串

* cut_all 参数用来控制是否采用全模式

* HMM 参数用来控制是否使用 HMM 模型

jieba.cut_for_search 方法接受两个参数

* 需要分词的字符串

* 是否使用 HMM 模型。

该方法适合用于搜索引擎构建倒排索引的分词,粒度比较细

# encoding=utf-8

import jieba

seg_list = jieba.cut("我在网易云课堂学习自然语言处理", cut_all=True)

print("Full Mode: " + "/ ".join(seg_list)) # 全模式

seg_list = jieba.cut("我在网易云课堂学习自然语言处理", cut_all=False)

print("Default Mode: " + "/ ".join(seg_list)) # 精确模式

seg_list = jieba.cut("他毕业于北京航空航天大学,在百度深度学习研究院进行研究") # 默认是精确模式

print(", ".join(seg_list))

seg_list = jieba.cut_for_search("小明硕士毕业于中国科学院计算所,后在斯坦福大学深造") # 搜索引擎模式

print(", ".join(seg_list))

print(jieba.lcut("我在网易云课堂学习自然语言处理"))

print(jieba.lcut_for_search("小明硕士毕业于中国科学院计算所,后在斯坦福大学深造"))

添加用户自定义字典

很多时候我们需要针对自己的场景进行分词,会有一些领域内的专有词汇。

1.可以用jieba.load_userdict(file_name)加载用户字典

2.少量的词汇可以自己用下面方法手动添加:

用 add_word(word, freq=None, tag=None) 和 del_word(word) 在程序中动态修改词典

用 suggest_freq(segment, tune=True) 可调节单个词语的词频,使其能(或不能)被分出来。

print('/'.join(jieba.cut('如果放到旧字典中将出错。', HMM=False)))

jieba.suggest_freq(('中', '将'), True)

print('/'.join(jieba.cut('如果放到旧字典中将出错。', HMM=False)))

import jieba.posseg as pseg

words = pseg.cut("我在网易云课堂学习自然语言处理")

for word, flag in words:

print('%s %s' % (word, flag))

c.关键词抽取

- 基于 TF-IDF 算法的关键词抽取